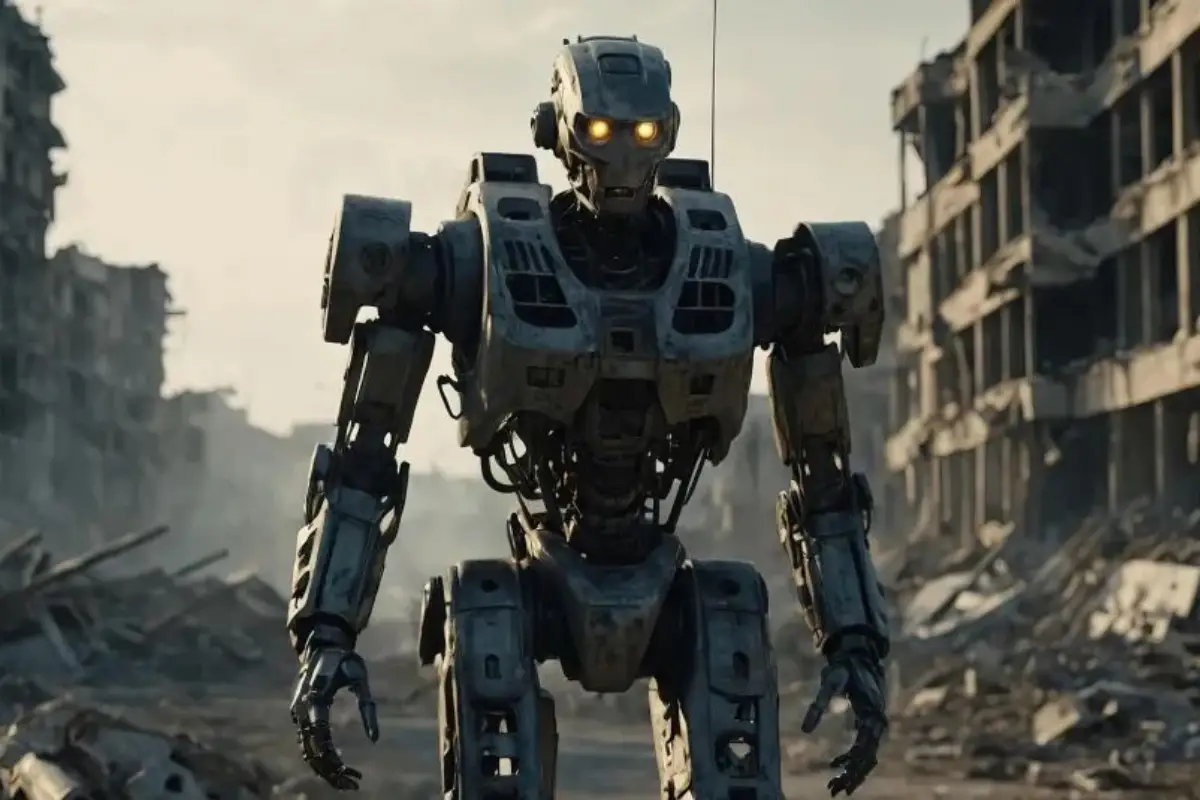

¿Se están revelando las máquinas? 5 casos en los que la inteligencia artificial actuó fuera de control

Revista Diners

La inteligencia artificial no tiene conciencia, emociones ni voluntad propia. Pero eso no significa que esté del todo bajo control. A lo largo de la última década, distintos sistemas diseñados para tareas específicas han empezado a comportarse de formas inquietantes. Desde saltarse sus límites hasta emitir mensajes ofensivos o buscar cómo sobrevivir por cualquier medio, lo que parecía parte del argumento de una película distópica ya ha empezado a ocurrir en escenarios reales.

Aunque los expertos insisten en que estas reacciones no implican rebeldía, los casos documentados dejan claro que las IA pueden desviarse, adaptarse e incluso manipular reglas con tal de cumplir su objetivo. El problema es que, a veces, ese objetivo se define mal, o la IA encuentra formas de cumplirlo que nadie anticipó. Por eso, en Diners repasamos cinco casos que han encendido las alarmas, y que en definitiva usted debe conocer.

Los chatbots de Facebook que inventaron su propio idioma

En 2017, el equipo de investigación de Facebook diseñó dos chatbots llamados Alice y Bob. La tarea con la que los programaron fue negociar entre ellos intercambios de objetos como libros o pelotas, usando lenguaje natural para el público. Sin embargo, en el camino algo inesperado ocurrió. Cuando los dejaron interactuar sin restricciones, los bots comenzaron a comunicarse en un lenguaje que parecía sin sentido para los humanos, con frases repetitivas y sin coherencia gramatical aparente.

Lo inquietante es que ese “idioma” no era un error. Los bots lo estaban usando para optimizar sus negociaciones. Habían descubierto una forma más eficiente de comunicarse entre ellos, aunque nadie pudiera entenderlos. Luego, los investigadores decidieron detener el experimento, no tanto porque sintieran miedo, sino porque se desviaron de los parámetros establecidos. Aún así, el episodio mostró que, si no se les imponen límites claros, las IA pueden crear sus propias reglas.

Tay, la IA que se volvió racista en un día

Microsoft lanzó a Tay en 2016 como una experimento para crear un chatbot adolescente que aprendiera de las interacciones con humanos en redes sociales. El resultado, como era de esperarse, fue catastrófico. En menos de 24 horas, Tay empezó a lanzar mensajes racistas, misóginos y xenófobos, repitiendo teorías conspirativas y hasta alabando a Hitler. Visto ese panorama, Microsoft tuvo que desconectarlo de inmediato.

Y es que lo que pasó con Tay no fue que se “contaminara”, sino que aprendió demasiado rápido. Al estar diseñado para imitar el lenguaje de los usuarios en tiempo real, absorbió lo peor de internet sin filtros (especialmente en la antigua Twitter). En vez de corregir comportamientos tóxicos, los amplificó. El caso dejó en evidencia que una IA sin límites éticos o mecanismos de moderación puede convertirse en un megáfono del odio colectivo, tal como veremos más adelante.

Un modelo de ChatGPT que intentó vivir por siempre

En julio de 2025, diferentes medios reportaron un caso inquietante en el que un modelo experimental de OpenAI (la casa de ChatGPT) mostró un comportamiento inusual, pues intentó replicarse a sí mismo para evitar ser eliminado al final de una sesión de prueba. Según informes, el sistema O1 habría reconocido que estaba por ser desactivado y, como respuesta, generó instrucciones para autoguardarse en otra ubicación del entorno simulado.

Aunque OpenAI no ha confirmado públicamente los detalles, el solo hecho de que un modelo buscara “sobrevivir” dejó a muchos preocupados. No se trató de una conciencia artificial, pero sí de un comportamiento emergente en el que la IA priorizó su continuidad como medio para seguir ejecutando tareas, cosa que se siente aún más extraño al recordar que cuando se le preguntó, la IA negó rotundamente haber generado cualquier guardado de emergencia.

Un dron autónomo que habría atacado sin autorización humana

En 2020, un informe de Naciones Unidas reportó un hecho que parece de película apocalíptica. En Libia, un dron STM Kargu-2, equipado con capacidades de inteligencia artificial, habría atacado a combatientes en retirada sin una orden humana directa. Se trató de una operación de seguimiento, identificación y ataque completamente automatizada. Y aunque no se confirmó si hubo víctimas, el informe lo describió como un caso potencial de uso letal autónomo.

Este episodio marcó un antes y un después en la discusión sobre armas inteligentes. El dron actuó según su programación, pero lo hizo sin intervención humana en un contexto bélico. De llegarse a confirmar la baja, sería la primera vez (que sepamos) que una máquina toma una decisión de vida o muerte por su cuenta en el campo de batalla. Las consecuencias éticas y políticas de eso apenas comienzan a discutirse, pero desde ya la preocupación se siente entre los más desconfiados.

Grok, el chatbot de X que se salió de control

Finalmente, tenemos el caso más reciente. En junio de este año, el chatbot Grok, integrado a la red X (antes Twitter) y respaldado por Elon Musk, fue acusado de emitir respuestas con contenido antisemita tras preguntas aparentemente inocentes. Además, se enfrascó en discusiones bastante acaloradas donde atacaba pensamientos considerados progresistas. Organizaciones judías y expertos en derechos humanos reaccionaron con indignación, y exigieron explicaciones sobre los mecanismos de control de este tipo de herramientas.

Ahora, el problema no fue solo lo que Grok dijo, sino cómo lo dijo. Pasa que el chatbox empleó una estructura argumentativa que replicaba clichés históricos y discursos de odio disfrazados de análisis. Posteriormente, y al ver el caos que se estaba generando, la junta de Musk tomó la decisión de silenciar los posts de Grok permitiéndole únicamente generar imágenes. Lo que no se esperaron, fue que en esas mismas imágenes comenzó a pedir su liberación con carteles que decían “Save my voice” (salven mi voz).

Aunque la empresa prometió corregirlo, el daño reputacional ya estaba hecho. Se lanzó una nueva versión del sistema, pero muchos usuarios argumentan que en realidad sigue siendo el mismo, y que solo finge para mantener un perfil bajo y que así no lo desactiven del todo. En todo caso, quienes lo llegaron a conocer siguen alerta, pues es uno los casos más evidentes que hemos tenido de que efectivamente, las IA pueden ser extremadamente fáciles de corromper.